Sztuczna inteligencja na podstawie naszego chodu odgadnie, czy czujemy złość, radość czy smutek17.07.2019

Mieliśmy już do czynienia z programami, które odczytują emocje z ludzkiej twarzy albo głosu. Teraz sztuczna inteligencja rozpozna je poprzez analizę samego sposobu chodzenia.

Nasze emocje potrafią zdefiniować nie tylko nasze myślenie, apetyt czy sen, ale to, jakim krokiem poruszamy się na ulicy. Naukowcy z Uniwersytetu Północnej Karoliny w Chapel Hill, a także z Uniwersytetu w Maryland postanowili stworzyć narzędzie, które na podstawie chodu określi kierujące człowiekiem emocje.

Badacze wykorzystali system uczenia maszynowego (ang. deep learning), w którym komputer nie wykonuje szeregu zaprogramowanych równań, a uczy się sam. Na podstawie zebranych danych tworzy reguły, sieci semantyczne, rozkłady prawdopodobieństwa albo drzewa decyzyjne. W ten sposób algorytm potrafi sam generować wnioski i analizować. Oczywiście zawsze istnieje próg błędu, bo według austriackiego filozofa, Karla Poppera „wiedza zdobyta w wyniku obserwacji ma charakter jedynie domyślny” (Conjectures and Refutations: The Growth of Scientific Knowledge 1963).

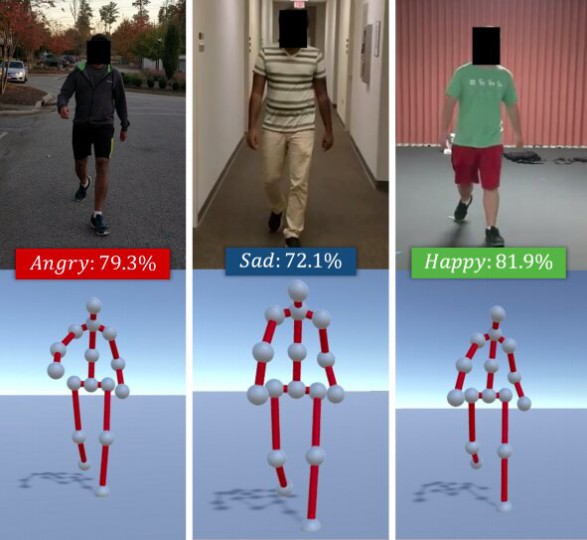

To właśnie na bazie deep learning badacze stworzyli oprogramowanie Emotion Walk (EWalk), które analizuje nagrania wideo z poruszającymi się w przestrzeni ludźmi. Sztuczna inteligencja wyciąga z ruchu dominujące elementy i przyporządkowuje je do konkretnych emocji. Analizuje informacje na bieżąco, w odniesieniu do tego, co już „widziała”.

Według opublikowanego niedawno badania, obecna metoda określa stan emocjonalny człowieka wobec jego chodu z dokładnością do 80 proc. Są to jednak proste, podstawowe emocje, jak radość, smutek, gniew albo neutralny stan.

Istnieją jednak głosy krytyki wobec oprogramowania. Zdaniem Aniketa Bery, profesora informatyki z Uniwersytetu Północnej Karoliny, który nadzorował badanie, same założenia są niewłaściwe. Sposób badania jest szacunkowy, funkcjonuje na zasadzie prognozy, bo nie ma dostępu do wszystkich niezbędnych danych dotyczących ludzkich emocji – koncentruje się jedynie na tym, co jest dostrzegalne na zewnątrz.

Mimo to stworzone narzędzie – jeśli będzie konsekwentnie rozwijane i ulepszane – może pomóc w lepszym programowaniu ruchów i zachowań robotów albo wirtualnej rzeczywistości.

zobacz także

- „Sonali”. Mac DeMarco w roli reżysera klipu Iggy'ego Popa

Newsy

„Sonali”. Mac DeMarco w roli reżysera klipu Iggy'ego Popa

- Ukryte koszty streamingu. Jak słuchanie muzyki wpływa na środowisko

Newsy

Ukryte koszty streamingu. Jak słuchanie muzyki wpływa na środowisko

- Gorillaz łączy siły z Thundercatem. Posłuchaj ich wspólnego utworu „Cracker Island”

Newsy

Gorillaz łączy siły z Thundercatem. Posłuchaj ich wspólnego utworu „Cracker Island”

- Igo rusza z karierą solową. Posłuchaj „Heleny" – pierwszego singla wokalisty

Newsy

Igo rusza z karierą solową. Posłuchaj „Heleny" – pierwszego singla wokalisty

zobacz playlisty

-

Papaya Young Directors top 15

15

15Papaya Young Directors top 15

-

Tim Burton

03

03Tim Burton

-

Paul Thomas Anderson

02

02Paul Thomas Anderson

-

Andriej Tarkowski

02

02Andriej Tarkowski