Naukowcy potrafią już zamienić pojedyncze zdjęcie w wideo. Wykorzystują do tego głębokie uczenie15.06.2021

Zespół z Uniwersytetu Waszyngtońskiego, dowodzony przez Aleksandra Hołyńskiego, pokazał możliwości projektu na przykładzie ujęcia wodospadu Snoqualmie Falls.

Na początku marca pisaliśmy o nowym, bezpłatnym narzędziu projektu My Heritage, które jest adresowane do wszystkich fanów genealogii i historii. Użytkownik może wypróbować je na dowolnym starym zdjęciu przedstawiającym daną osobę. Wyszkolony algorytm dokonuje analizy fotografii, a następnie dobiera do niej kilkusekundową animację ze zmieniającą się mimiką. W ten sposób postacie z przyszłości ożywiają, stając się cyfrowymi avatarami i nietypową wariacją na temat coraz popularniejszych deepfake'ów.

Animowanie statycznych kadrów to wyzwanie, które niegdyś było pozornie nieosiągalną wizją w głowach futurologów. Dzięki zdobyczom nowych technologii zmiana zdjęcia w wideo powszednieje, do czego cegiełkę dołożyli właśnie naukowcy z Uniwersytetu Waszyngtońskiego. – Fotografia rejestruje moment zaklęty w czasie. W nieruchomym obrazie gubi się jednak wiele informacji. Co go ukształtowało i jak zmieniają się rzeczy? – zastanawiał się jeden ze współautorów badania, Aleksander Hołyński. – W naszej metodzie postawiliśmy na to, żeby użytkownik nie musiał jakkolwiek działać i wprowadzać dodatkowych informacji. Wszystko, czego potrzebujemy, to zdjęcie – dodaje.

Amerykanin tłumaczy, że podczas prac nad mechanizmem stanęli przed niełatwym wyzwaniem przewidzenia tego, co dalej dzieje się w udokumentowanych sytuacjach. Badacze ograniczyli się dlatego do animacji płynięcia różnych gazowych i ciekłych substancji: wody, chmur, dymu oraz lawy. Aby realistycznie je odwzorować, wytrenowali za pomocą głębokiego uczenia sztuczne sieci neuronowe. W tym celu dostarczyli jej tysiące filmów z wodospadami, oceanami czy rzekami. Algorytm nauczył się identyfikować wskazówki dotyczące tego, w którą stronę nastąpi ruch. Mogły to być nawet najdrobniejsze drgania albo fale.

Kolejnym krokiem specjalistów z Uniwersytetu Waszyngtońskiego było wykorzystanie metody, którą określili mianem „symmetric splatting". Porusza ona każdym pikselem zgodnie z jego przewidywalną rotacją, ale uwzględnia również to, gdzie znajdował się wcześniej. – Integrujemy dane z obu animacji, dzięki czemu w naszych obrazach nie ma rażących luk – podkreśla Hołyński. Dalej Amerykanie postawili na zapętlenie obrazu, tworząc wrażenie ciągłej akcji.

Sztuczne sieci neuronowe najlepiej działają w przypadku obiektów o przewidywalnym, płynnym ruchu. – Chcielibyśmy jednak rozszerzyć nasz projekt o inne sytuacje, na przykład poprzez animowanie włosów człowieka powiewających na wietrze – zapowiada Hołyński. Szczegółowe omówienie prac jego zespołu opublikowano na łamach uczelnianego bloga.

zobacz także

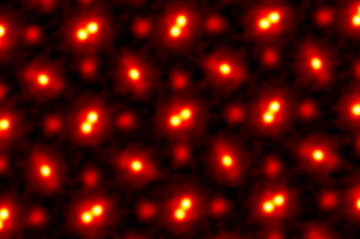

- Naukowcy z Uniwersytetu Cornella opracowali mikroskop elektronowy o rekordowej rozdzielczości

Newsy

Naukowcy z Uniwersytetu Cornella opracowali mikroskop elektronowy o rekordowej rozdzielczości

- Portal do innego miasta. Wilno i Lublin połączą „wirtualne wrota”

Newsy

Portal do innego miasta. Wilno i Lublin połączą „wirtualne wrota”

- Zaginanie filmowej czasoprzestrzeni. Obejrzyj spektakularne slow motion Bena Ouaniche’a

Newsy

Zaginanie filmowej czasoprzestrzeni. Obejrzyj spektakularne slow motion Bena Ouaniche’a

- Trzeci kciuk. Naukowcy sprawdzili, jak wyglądałoby nasze życie z dodatkowym palcem

Newsy

Trzeci kciuk. Naukowcy sprawdzili, jak wyglądałoby nasze życie z dodatkowym palcem

zobacz playlisty

-

05

05 -

Seria archiwalnych koncertów Metalliki

07

07Seria archiwalnych koncertów Metalliki

-

Original Series Season 1

03

03Original Series Season 1

-

Paul Thomas Anderson

02

02Paul Thomas Anderson